据DeepSeek 官微消息,DeepSeek今日发布两个正式版模型:DeepSeek-V3.2和DeepSeek-V3.2-Speciale。

DeepSeek吉祥物

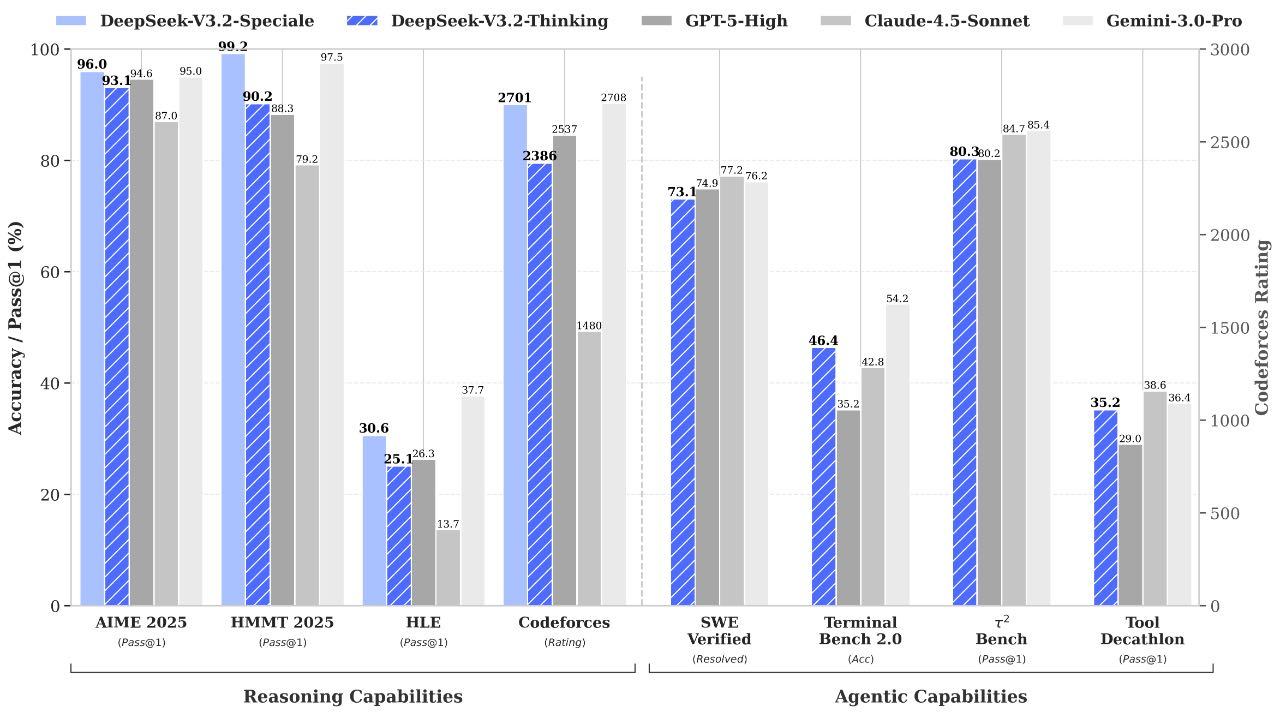

据悉,DeepSeek-V3.2的目标是平衡推理能力与输出长度,适合日常使用。在公开的推理类Benchmark测试中,DeepSeek-V3.2达到了GPT-5的水平,仅略低于Gemini-3.0-Pro;相比Kimi-K2-Thinking,V3.2的输出长度大幅降低,显著减少了计算开销与用户等待时间。

DeepSeek-V3.2-Speciale的目标是将开源模型的推理能力推向极致,探索模型能力的边界。V3.2-Speciale是DeepSeek-V3.2的长思考增强版,同时结合了DeepSeek-Math-V2的定理证明能力。V3.2-Speciale模型成功斩获IMO 2025(国际数学奥林匹克)、CMO 2025(中国数学奥林匹克)、ICPC World Finals 2025(国际大学生程序设计竞赛全球总决赛)及 IOI 2025(国际信息学奥林匹克)金牌。

两大模型各有千秋:日常利器与科研尖兵

DeepSeek-V3.2定位“平衡实用”。官方数据显示,其在推理基准测试中达GPT-5水平,略低于Gemini-3.0-Pro。相比同类思考模型,其显著缩短输出长度,降低计算开销与等待时间,适用于日常问答、通用Agent任务及真实场景工具调用。

DeepSeek官微称其“在Agent评测中达到当前开源模型最高水平”,且未针对测试工具进行特殊训练。

DeepSeek-V3.2-Speciale则为“极致推理”而生,是V3.2的长思考增强版,融合DeepSeek-Math-V2定理证明能力。该模型在IMO 2025(国际数学奥林匹克)、CMO 2025、ICPC 2025总决赛及IOI 2025中均达到金牌水准,其中ICPC成绩相当于人类选手第二,IOI相当于第十名。

DeepSeek Sparse Attention(DSA)首次实现了细粒度稀疏注意力机制,在几乎不影响模型输出效果的前提下,实现了长文本训练和推理效率的大幅提升。

该版本未优化日常对话,不支持工具调用,专攻复杂数学推理、编程竞赛与学术研究,消耗Token更多,成本更高。

DeepSeek这次有了高效架构与强化学习突破

技术报告揭示了关键创新。DSA稀疏注意力机制将长序列处理复杂度从传统的O(L²)降至近似线性O(L·k)。通过“闪电索引器”与“细粒度token选择”,在128K长度序列上,推理成本比前代降低数倍:预填充阶段每百万token成本从约0.7美元降至0.2美元,解码阶段从2.4美元降至0.8美元。

强化学习训练投入空前,计算预算超预训练成本10%。团队改进GRPO算法,采用无偏KL估计、离线序列掩码策略及针对MoE模型的“保持路由”操作,确保训练稳定。通过专家蒸馏策略,先训练数学、编程等6大领域专家模型,再整合训练最终模型。

Agent能力:推理与工具调用深度融合

V3.2在Agent能力上取得关键突破。创新的思考上下文管理机制,改变以往丢弃历史推理内容的策略,仅在引入新用户消息时丢弃推理内容,而保留工具调用历史与结果,提升多轮任务连贯性。

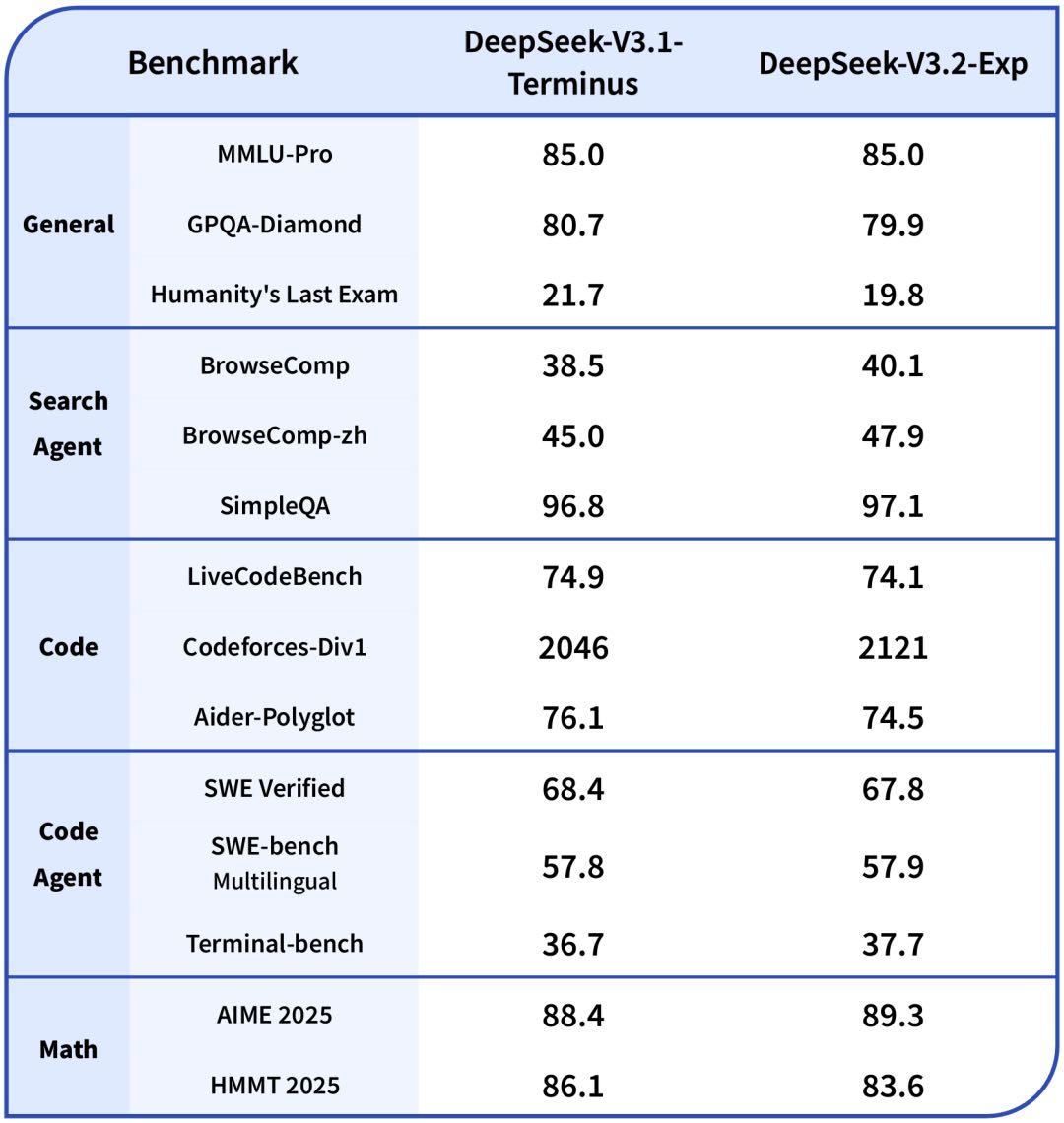

在各领域的公开评测集上,DeepSeek-V3.2-Exp 的表现与 V3.1-Terminus 基本持平。

训练数据方面,构建自动环境合成管线,生成1827个任务环境与超85000个复杂提示。代码Agent从GitHub挖掘数百万issue-PR对,构建数万个可执行问题解决环境。

评测显示,V3.2在SWE-Verified上解决率达73.1%,在Terminal Bench 2.0上准确率46.4%,显著超越现有开源模型。在多项工具使用基准上,表现已接近领先闭源模型。

此次双模型发布,不仅展示了DeepSeek在高效架构、强化学习与Agent能力的进展,更规划了开源模型实用化与探索极限的双路径,为全球开源社区提供新标杆。

目前,用户可通过官方渠道直接体验DeepSeek-V3.2;研究者可申请使用Speciale临时API,探索其极致推理能力。

来源:潮新闻